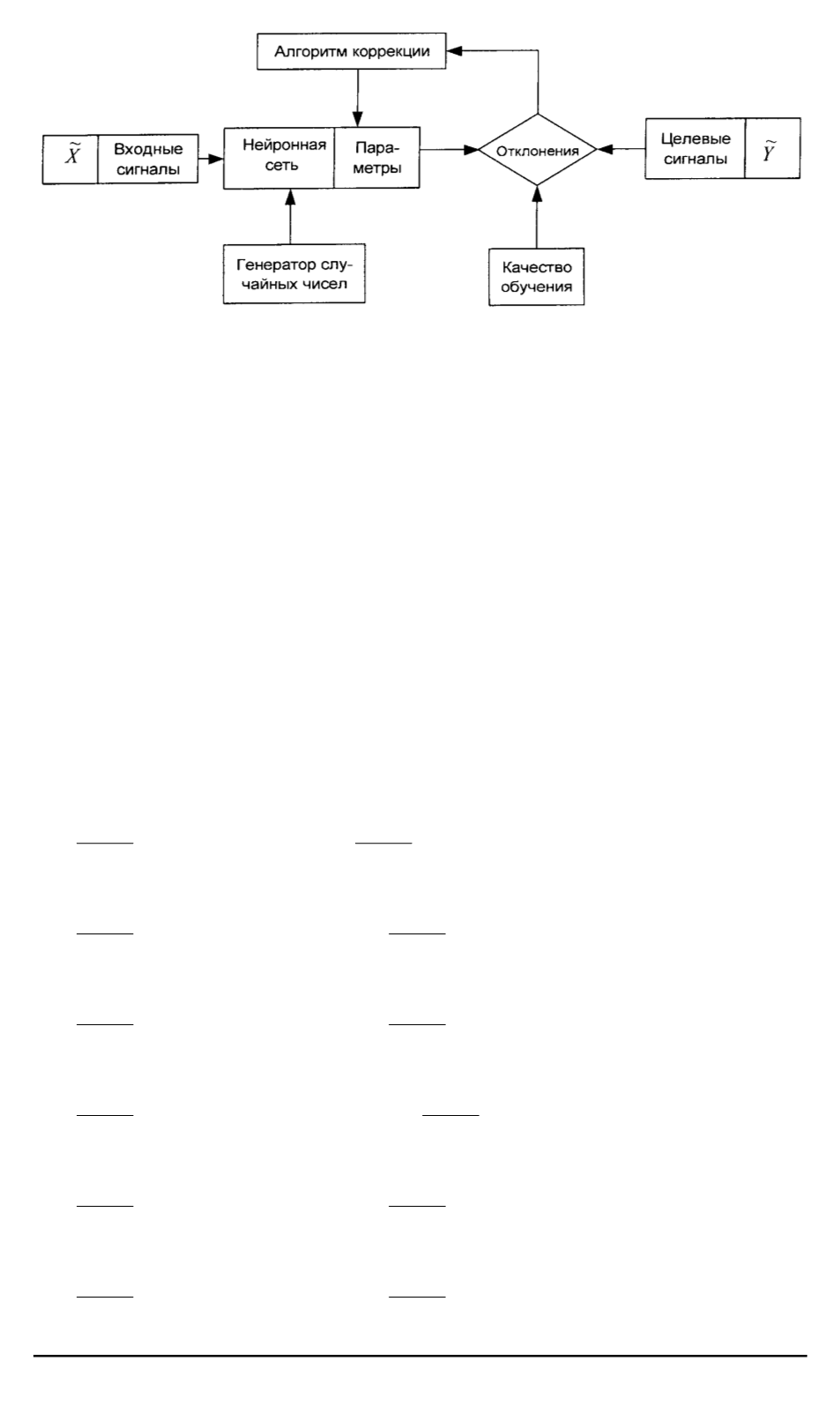

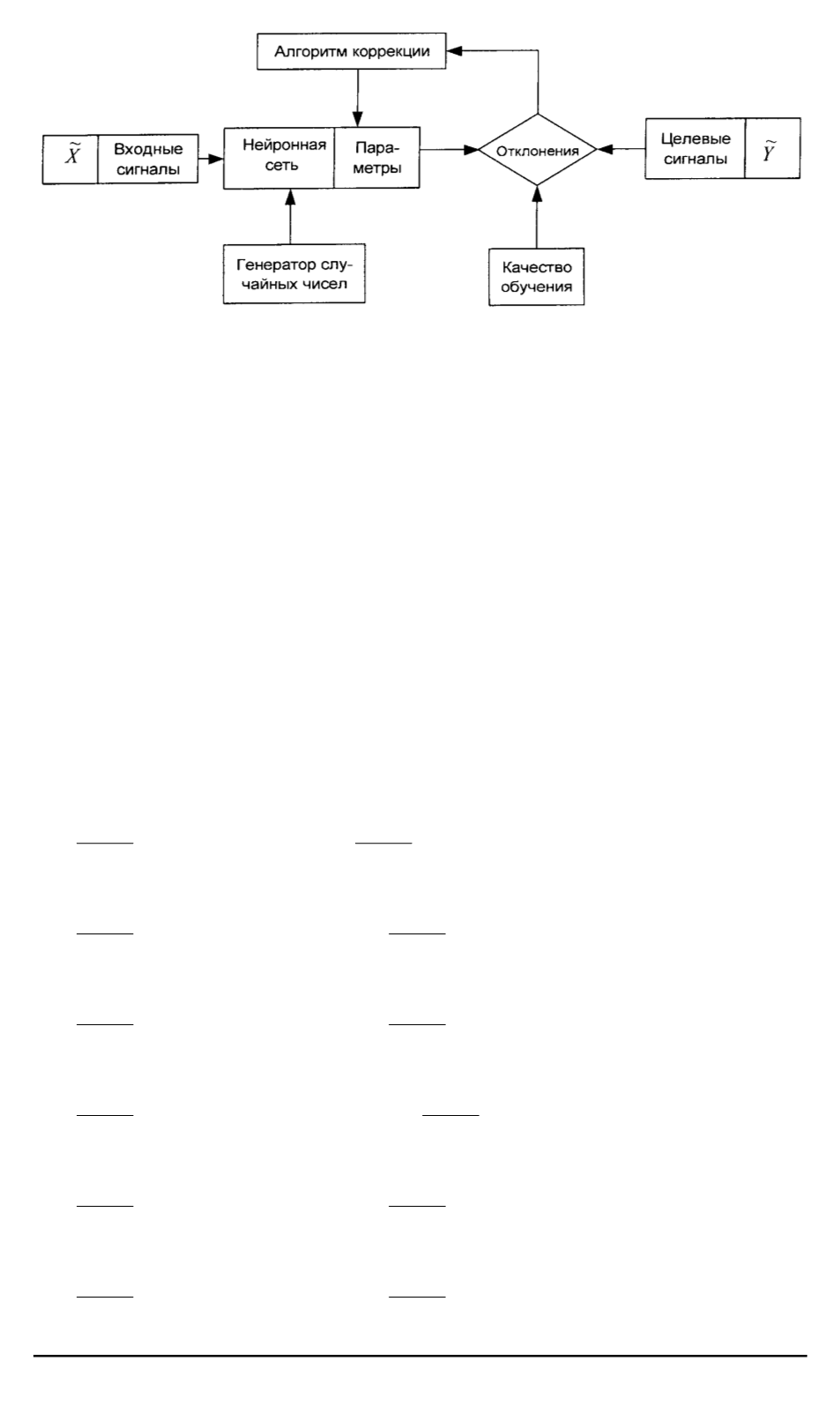

Рис. 3. Схема обучения параметров сети (обучение с обратной связью)

Здесь

a

c

rs

1

,

a

н

rs

1

,

a

c

rs

2

,

a

н

rs

2

— старые и новые значения левой и правой

части параметров НС;

˜

a

rs

= [

a

rs

1

, a

rs

2

]

;

γ

— скорость обучения.

Структура нейронной сети для идентификации параметров урав-

нения (1) приведена на рис. 4.

Для уравнения (2) рассмотрим конкретный частный случай в виде

уравнения регрессии второго порядка:

˜

Y

= ˜

a

00

+ ˜

a

10

˜

x

1

+ ˜

a

01

˜

x

2

+ ˜

a

11

˜

x

1

˜

x

2

+ ˜

a

20

˜

x

2

1

+ ˜

a

02

˜

x

2

2

.

(3)

Для решения уравнения (2) построим нейронную структуру, где в

качестве параметров сети выступают коэффициенты

˜

a

00

,

˜

a

10

,

˜

a

01

,

˜

a

11

,

˜

a

20

,

˜

a

02

. При этом структура будет иметь четыре входа и один выход

(рис. 5).

Используя нейросетевую структуру, осуществим обучение параме-

тров сети. Для значения

α

= 0

получим следующие выражения:

∂E

1

∂a

001

=

k

X

j

=1

(

y

j

1

−

t

j

1

);

∂E

2

∂a

002

=

k

X

j

=1

(

y

j

2

−

t

j

2

);

∂E

1

∂a

101

=

k

X

j

=1

(

y

j

1

−

t

j

1

)

x

11

;

∂E

2

∂a

102

=

k

X

j

=1

(

y

j

2

−

t

j

2

)

x

12

;

∂E

1

∂a

011

=

k

X

j

=1

(

y

j

1

−

t

j

1

)

x

21

;

∂E

2

∂a

012

=

k

X

j

=1

(

y

j

2

−

t

j

2

)

x

22

;

∂E

1

∂a

111

=

k

X

j

=1

(

y

j

1

−

t

j

1

)

x

11

x

21

;

∂E

2

∂a

112

=

k

X

j

=1

(

y

j

2

−

t

j

2

)

x

12

x

22

;

∂E

1

∂a

201

=

k

X

j

=1

(

y

j

1

−

t

j

1

)

x

2

11

;

∂E

2

∂a

202

=

k

X

j

=1

(

y

j

2

−

t

j

2

)

x

2

12

;

∂E

1

∂a

021

=

k

X

j

=1

(

y

j

1

−

t

j

1

)

x

2

21

;

∂E

2

∂a

022

=

k

X

j

=1

(

y

j

2

−

t

j

2

)

2

x

2

22

.

(4)

ISSN 0236-3941. Вестник МГТУ им. Н.Э. Баумана. Сер. “Машиностроение”. 2006. № 2 103